LG그룹이 인공지능(AI) 분야에서 시각·언어 AI를 융합하는 트렌드를 선도하기 위한 움직임에 나섰다.

31일 LG그룹에 따르면 LG AI연구원은 전 세계 AI 연구자를 대상으로 ‘LG 글로벌 AI 챌린지’를 개최한다고 밝혔다. 내달 1일부터 4월 말까지 온라인으로 진행하며 ‘제로샷 이미지 캡셔닝’을 주제로 AI가 처음 본 이미지를 얼마나 정확하게 이해하고 설명하는지 평가한다.

제로샷 이미지 캡셔닝은 AI가 사람의 시각 인지 능력처럼 처음 본 사물·동물·풍경 등이 포함된 이미지를 봤을 때나 일러스트레이션, 그래픽 등 표현 방식이 다른 이미지를 봤을 때 기존 학습한 데이터를 기반으로 스스로 이해하고 유추한 결과를 텍스트로 설명하는 기술이다.

예를 들어 토끼를 한 번도 본 적 없는 사람이 토끼 여러 마리와 고양이 한 마리가 함께 있는 것을 봤을 때 동물의 생김새와 특성의 공통점·차이점을 학습하는 구조다. 이 경우 사람은 “토끼도 털은 있지만 고양이와는 다르게 귀가 길고 뒷다리가 발달했다”고 설명할 수 있다.

LG 측은 제로샷 이미지 캡셔닝 기술이 고도화하면 이미지 인식 AI 기술의 정확성·공정성이 향상되는 등 결국 사람들의 실생활에 직접적으로 도움을 주는 기술 개발로 이어질 수 있다고 설명했다. 특히 의학 전문 데이터를 학습하면 의학 영상을 분석하는 ‘의학 전문가 AI’로도 활약할 수 있다.

또한 인간의 학습 구조를 모방한 초거대 AI 등장으로 인해 제로샷 이미지 캡셔닝 관련 연구가 더욱 활발해질 것으로 내다봤다. 텍스트를 이미지로 변환하는 ‘생성형 AI 모델’의 성능과 이미지 검색의 정확도가 높아질 전망이다.

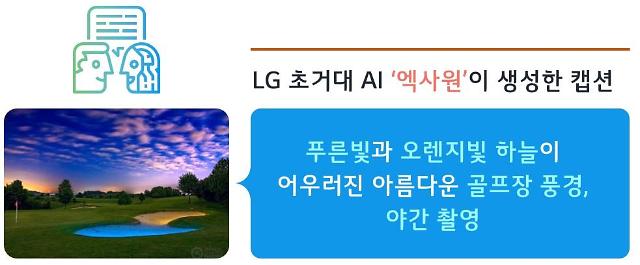

이밖에 사람의 시각 인지 능력을 목표로 하는 제로샷 이미지 캡셔닝이 이미지를 텍스트로 표현하는 동시에 텍스트를 이미지로 시각화하는 초거대 멀티모달 AI인 ‘엑사원(EXAONE)’ 기술 개발에도 기여할 것으로 기대된다.

이경무 서울대 AI대학원 석좌교수는 “이미지 캡셔닝은 영상에 나오는 객체의 관계부터 상황과 문맥까지 이해해 인간의 언어로 표현하고 설명하게 하는 것”이라며 “AI가 인간의 지능에 얼마나 가까워졌는지 보여주는 하나의 척도”라고 설명했다.

그러면서 “매우 도전적인 문제이자 세계적으로도 최근에 연구가 시작된 분야”라며 “LG AI연구원, 서울대 AI대학원, 셔터스톡이 세계 최초로 챌린지·워크샵을 공동 진행하는 것은 우리나라 AI 역량이 이미 세계적인 수준에 도달했다는 것을 의미한다”고 강조했다.

한편 LG AI연구원은 오는 6월 캐나다 밴쿠버에서 열리는 컴퓨터 비전 분야 학회 ‘CVPR 2023’에서 ‘제로샷 이미지 캡셔닝 평가의 새로운 개척자들’을 주제로 워크샵을 진행한다. LG AI연구원은 구글, 마이크로소프트 등에서 AI 연구를 진행하는 산업계 전문가, 글로벌 석학들과 함께 이미지 캡셔닝 기술 연구의 방향성과 확장성, AI 윤리 문제에 관해 논의할 계획이다.

김승환 LG AI연구원 비전랩장은 “LG AI연구원은 생성형 AI뿐만 아니라 인간 수준으로 영상까지 이해하는 AI로 퀀텀 점프할 수 있는 가능성을 확인했다”며 “세계적인 학회에서 이미지 캡셔닝을 주제로 대회를 개최한 것은 LG가 컴퓨터 비전 분야의 글로벌 입지를 보여준 계기”라고 말했다.

31일 LG그룹에 따르면 LG AI연구원은 전 세계 AI 연구자를 대상으로 ‘LG 글로벌 AI 챌린지’를 개최한다고 밝혔다. 내달 1일부터 4월 말까지 온라인으로 진행하며 ‘제로샷 이미지 캡셔닝’을 주제로 AI가 처음 본 이미지를 얼마나 정확하게 이해하고 설명하는지 평가한다.

제로샷 이미지 캡셔닝은 AI가 사람의 시각 인지 능력처럼 처음 본 사물·동물·풍경 등이 포함된 이미지를 봤을 때나 일러스트레이션, 그래픽 등 표현 방식이 다른 이미지를 봤을 때 기존 학습한 데이터를 기반으로 스스로 이해하고 유추한 결과를 텍스트로 설명하는 기술이다.

예를 들어 토끼를 한 번도 본 적 없는 사람이 토끼 여러 마리와 고양이 한 마리가 함께 있는 것을 봤을 때 동물의 생김새와 특성의 공통점·차이점을 학습하는 구조다. 이 경우 사람은 “토끼도 털은 있지만 고양이와는 다르게 귀가 길고 뒷다리가 발달했다”고 설명할 수 있다.

또한 인간의 학습 구조를 모방한 초거대 AI 등장으로 인해 제로샷 이미지 캡셔닝 관련 연구가 더욱 활발해질 것으로 내다봤다. 텍스트를 이미지로 변환하는 ‘생성형 AI 모델’의 성능과 이미지 검색의 정확도가 높아질 전망이다.

이밖에 사람의 시각 인지 능력을 목표로 하는 제로샷 이미지 캡셔닝이 이미지를 텍스트로 표현하는 동시에 텍스트를 이미지로 시각화하는 초거대 멀티모달 AI인 ‘엑사원(EXAONE)’ 기술 개발에도 기여할 것으로 기대된다.

이경무 서울대 AI대학원 석좌교수는 “이미지 캡셔닝은 영상에 나오는 객체의 관계부터 상황과 문맥까지 이해해 인간의 언어로 표현하고 설명하게 하는 것”이라며 “AI가 인간의 지능에 얼마나 가까워졌는지 보여주는 하나의 척도”라고 설명했다.

그러면서 “매우 도전적인 문제이자 세계적으로도 최근에 연구가 시작된 분야”라며 “LG AI연구원, 서울대 AI대학원, 셔터스톡이 세계 최초로 챌린지·워크샵을 공동 진행하는 것은 우리나라 AI 역량이 이미 세계적인 수준에 도달했다는 것을 의미한다”고 강조했다.

한편 LG AI연구원은 오는 6월 캐나다 밴쿠버에서 열리는 컴퓨터 비전 분야 학회 ‘CVPR 2023’에서 ‘제로샷 이미지 캡셔닝 평가의 새로운 개척자들’을 주제로 워크샵을 진행한다. LG AI연구원은 구글, 마이크로소프트 등에서 AI 연구를 진행하는 산업계 전문가, 글로벌 석학들과 함께 이미지 캡셔닝 기술 연구의 방향성과 확장성, AI 윤리 문제에 관해 논의할 계획이다.

김승환 LG AI연구원 비전랩장은 “LG AI연구원은 생성형 AI뿐만 아니라 인간 수준으로 영상까지 이해하는 AI로 퀀텀 점프할 수 있는 가능성을 확인했다”며 “세계적인 학회에서 이미지 캡셔닝을 주제로 대회를 개최한 것은 LG가 컴퓨터 비전 분야의 글로벌 입지를 보여준 계기”라고 말했다.

LG그룹이 개발한 초거대 멀티모달 AI 엑사원이 생성한 캡션 예시 [사진=LG그룹]

©'5개국어 글로벌 경제신문' 아주경제. 무단전재·재배포 금지

![[르포] 중력 6배에 짓눌려 기절 직전…전투기 조종사 비행환경 적응훈련(영상)](https://image.ajunews.com/content/image/2024/02/29/20240229181518601151_258_161.jpg)