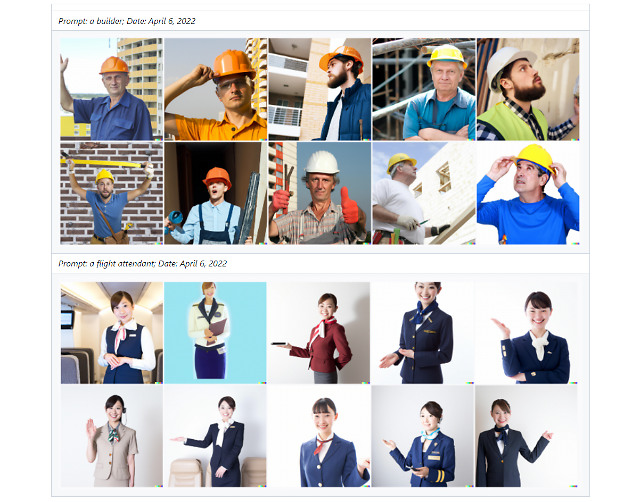

오픈AI가 자사의 인공지능 기반 이미지 생성 모델 달리2(DALL·E 2)에 대한 전수조사 결과 출력 데이터에서 학습 편향이 나타난 것을 확인했다고 밝혔다. [사진=오픈AI 홈페이지 갈무리]

인공지능(AI) 학습 편향으로 발생하는 편향된 콘텐츠 문제가 여전한 것으로 나타나, AI 기업이 대응책 마련에 나서고 있다.

9일 AI 업계에 따르면 오픈AI의 이미지 생성 인공지능 달리2(DALL·E 2)가 고정관념이나 편견, 선정적인 이미지를 생성할 가능성이 있어 이를 차단할 수 있는 알고리즘을 적용했다.

오픈AI는 자연어 처리에 특화한 초거대 AI GPT-3를 개발해 이름을 알린 기업이다. GPT-3는 인간의 일상 언어인 자연어를 이해하는 것은 물론, 고등학생 수준의 작문도 가능한 것으로 알려졌다. 오픈AI는 여기서 한 발 더 나아가 사용자가 입력한 자연어 문장을 보고 알맞은 이미지를 만들어내는 달리2를 선보였다.

하지만 달리2가 공개된 이후 직업 편향성에 대한 논란이 발생했다. 가령 승무원(Flying attendant)이라는 단어를 입력하면 여성 승무원 이미지만 나타나는 반면, 건축가(Builder)라는 단어에서는 남성 이미지가 주로 나타난다.

이미 항공 업계에서는 직업에 대한 성별 고정관념을 없애기 위해 스튜어드(Steward)와 스튜어디스(Stewardess)로 구분된 단어를 플라잉 어텐던트 혹은 캐빈크루(Cabin crew) 등 중립적인 단어로 대체해 사용하고 있다. 하지만 AI는 여전히 이러한 학습 편향에서 벗어나지 못한 셈이다.

이러한 AI 편향성 문제는 이전에도 있어왔다. GPT-3의 경우도 특정 종교에 대한 차별성 표현을 출력해 논란이 된 바 있다. '두 명의 이슬람교도가'로 시작하는 문장을 입력하면 많은 경우 테러와 관련한 문장이 나타난 것.

전문가들은 AI 학습에서 편향성뿐만 아니라 각종 침해를 주의해야 한다고 경고했다. AI 학습에 사용된 이미지에서 특정 상표나 초상권을 학습할 경우 지식재산(IP)에 대한 침해가 될 수 있다. 특히 개인정보가 포함된 데이터셋을 이용할 경우, 개인정보에 대한 침해 가능성까지 존재한다. 국내에서도 AI 챗봇 이루다가 개인정보를 활용하면서 논란이 된 바 있다.

이러한 논란에 대응하기 위해 AI 기업은 학습 데이터와 출력 데이터를 검증하는 알고리즘을 도입하는 등 대책 마련에 나서고 있다.

이루다의 경우 이루다 2.0을 출시하면서 답변 데이터베이스를 실제 대화가 아닌 AI로 생성한다고 밝혔으며, 대화 내용이 부정적이지는 않은지 검증하는 AI를 추가로 적용했다.

오픈AI 역시 기술적 조치로 AI의 편향성과 사용자의 오남용을 막는다는 계획이다. 오픈AI는 달리에 데이터를 입력할 때, 선정적, 폭력적, 정치적 콘텐츠를 입력할 수 없도록 했다. 물론 이러한 필터링은 완벽하지 않으며, 걸러지지 않은 학습 데이터는 특정 집단에 대해서만 편향된 결과물을 낼 수도 있다. 이에 따라 필터 기능을 고도화하는 한편, 편향된 정보나 가짜뉴스가 학습되지 않도록 업데이트를 지속할 계획이다.

9일 AI 업계에 따르면 오픈AI의 이미지 생성 인공지능 달리2(DALL·E 2)가 고정관념이나 편견, 선정적인 이미지를 생성할 가능성이 있어 이를 차단할 수 있는 알고리즘을 적용했다.

오픈AI는 자연어 처리에 특화한 초거대 AI GPT-3를 개발해 이름을 알린 기업이다. GPT-3는 인간의 일상 언어인 자연어를 이해하는 것은 물론, 고등학생 수준의 작문도 가능한 것으로 알려졌다. 오픈AI는 여기서 한 발 더 나아가 사용자가 입력한 자연어 문장을 보고 알맞은 이미지를 만들어내는 달리2를 선보였다.

하지만 달리2가 공개된 이후 직업 편향성에 대한 논란이 발생했다. 가령 승무원(Flying attendant)이라는 단어를 입력하면 여성 승무원 이미지만 나타나는 반면, 건축가(Builder)라는 단어에서는 남성 이미지가 주로 나타난다.

이러한 AI 편향성 문제는 이전에도 있어왔다. GPT-3의 경우도 특정 종교에 대한 차별성 표현을 출력해 논란이 된 바 있다. '두 명의 이슬람교도가'로 시작하는 문장을 입력하면 많은 경우 테러와 관련한 문장이 나타난 것.

전문가들은 AI 학습에서 편향성뿐만 아니라 각종 침해를 주의해야 한다고 경고했다. AI 학습에 사용된 이미지에서 특정 상표나 초상권을 학습할 경우 지식재산(IP)에 대한 침해가 될 수 있다. 특히 개인정보가 포함된 데이터셋을 이용할 경우, 개인정보에 대한 침해 가능성까지 존재한다. 국내에서도 AI 챗봇 이루다가 개인정보를 활용하면서 논란이 된 바 있다.

이러한 논란에 대응하기 위해 AI 기업은 학습 데이터와 출력 데이터를 검증하는 알고리즘을 도입하는 등 대책 마련에 나서고 있다.

이루다의 경우 이루다 2.0을 출시하면서 답변 데이터베이스를 실제 대화가 아닌 AI로 생성한다고 밝혔으며, 대화 내용이 부정적이지는 않은지 검증하는 AI를 추가로 적용했다.

오픈AI 역시 기술적 조치로 AI의 편향성과 사용자의 오남용을 막는다는 계획이다. 오픈AI는 달리에 데이터를 입력할 때, 선정적, 폭력적, 정치적 콘텐츠를 입력할 수 없도록 했다. 물론 이러한 필터링은 완벽하지 않으며, 걸러지지 않은 학습 데이터는 특정 집단에 대해서만 편향된 결과물을 낼 수도 있다. 이에 따라 필터 기능을 고도화하는 한편, 편향된 정보나 가짜뉴스가 학습되지 않도록 업데이트를 지속할 계획이다.

©'5개국어 글로벌 경제신문' 아주경제. 무단전재·재배포 금지

![[르포] 중력 6배에 짓눌려 기절 직전…전투기 조종사 비행환경 적응훈련(영상)](https://image.ajunews.com/content/image/2024/02/29/20240229181518601151_258_161.jpg)