연초부터 언어처리 분야 인공지능(AI) 연구에서 신기술 경쟁이 한창이다. 아마존과 마이크로소프트의 지원을 받는 AI 연구소 '오픈AI(OpenAI)'가 지난해 초대형 언어AI 모델 'GPT-3'를 선보인 데 이어, 구글 브레인(Google Brain) 소속 AI 연구팀이 GPT-3보다도 거대한 언어AI 모델 '스위치 트랜스포머(Switch Transformer)'를 최근 발표했다.

19일 출간 전 논문 공개 웹사이트 '아카이브(arxiv)'에는 구글 브레인 연구원 3명이 공동 작성한 논문 '스위치 트랜스포머: 단순하고 효율적인 희소성을 사용해 조(兆) 단위 파라미터 모델 확장하기'가 게재돼 있다. 논문에 소개된 모델은 1조6000억개의 파라미터(모델 내부의 변수)를 사용한다. 최초의 '조 단위' 파라미터 모델이자, 현존 최대 규모의 모델이다.

파라미터는 모델이 처리하는 데이터를 계산해 결정되는 변수를 뜻한다. 파라미터가 많을수록 AI가 추론한 결과물이 정교해지지만, 그만큼 많은 데이터를 처리해야 하기 때문에 모델의 크기가 방대해진다. 동시에 이를 처리하기 위한 소요 시간과 처리에 필요한 전산 자원은 더욱 늘어난다. 결과물이 같다면, 단시간에 적은 자원을 사용하는 모델이 우수한 것이다.

특히 이 논문은 기존 대비 시간과 자원을 더 효율적으로 쓸 수 있는 기법을 연구해, 한정된 시간과 자원으로 데이터 처리 규모를 크게 늘린 성과를 제시하고 있다. 구글 연구진들은 최대 110억개 파라미터를 사용한 언어 모델 'T5' 시리즈와 동일한 연산 자원을 활용하면서도, 기존보다 4~7배 빠른 속도로 조 단위 규모의 파라미터를 사용하는 새 모델을 학습시켰다.

구글 연구원들은 이 기법을 '다국어T5(mT5·Multilingual T5)' 개발 방식으로도 활용할 수 있다고 설명했다. mT5 모델은 T5 시리즈에 100여개의 언어 데이터를 사전학습(pre-training)시킨 것으로, 작년 11월 공개됐다. 스위치 트랜스포머의 최적화 기법을 활용하면 mT5의 사전학습 언어 가운데 91%의 언어를 4배 빠른 속도로 사전학습시킬 수 있다.

스위치 트랜스포머는 아직 연구자들에게 논문과 소스코드 형태로만 공개됐다. 이와 달리, 작년에 1750억개의 파라미터를 사용해 정교한 글을 쓰는 모델로 출시된 GPT-3는 외부 개발자들이 활용할 수 있는 현존 최대 언어 모델이다. GPT-3를 개발한 곳은 민간연구소 오픈AI지만 그 후원사 명단엔 역시 글로벌 빅테크 기업인 아마존과 MS가 이름을 올리고 있다.

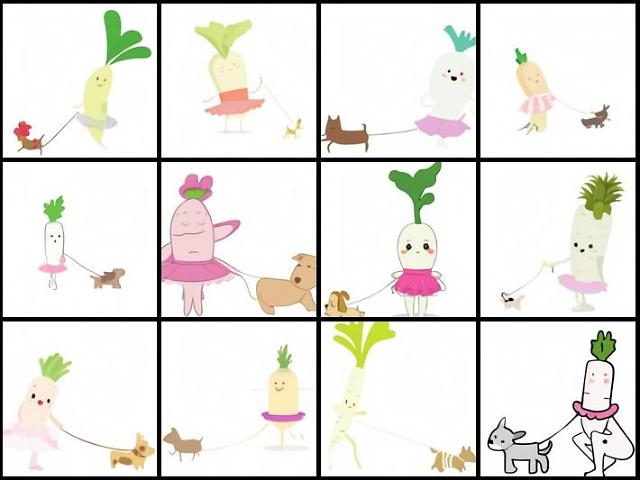

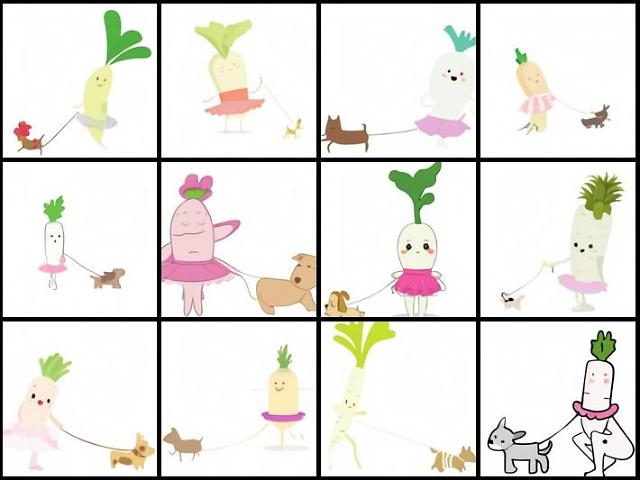

오픈AI는 올해 초 GPT-3를 활용해 '달리(DALL·E)'라는 또다른 AI 모델을 선보였다. 이 모델은 문장으로 표현하면 그에 맞는 그림을 만들어내는 '화가' AI다. "간판에 'GPT'라고 적힌 가게 앞", "아보카도 모양의 팔걸이 의자", "개를 산책시키고 있는 아기 조선무 일러스트" 등 사진 합성·편집부터 추상적인 개념의 연결과 사물 의인화까지 가능하다.

빅테크 기업들의 지원을 받고 있는 AI 연구진들의 경쟁 양상은 규모 싸움을 넘어 더욱 다양화되는 모습이다. 작년까지 오픈AI도 작년 GPT-3를 선보일 때까지는 기존 GPT 시리즈 모델에서 파라미터 수를 크게 늘리는 데 주력해 왔다. 하지만 GPT-3를 기반으로 만들어진 달리는 오히려 파라미터 수가 120억개로 오리지널 GPT-3보다 크게 줄었다.

다만 이같은 글로벌 기업들의 최신 AI 연구도 기존 대비 획기적인 패러다임 전환으로 볼만한 사례로 인정되진 않는 모습이다.

네덜란드 IT전문매체 더넥스트웹은 구글 브레인 연구진들의 스위치 트랜스포머 논문 내용을 소개하며 "더 적은 연산량으로 더 좋은 결과를 얻을 수 있는 기법이 가능하다는 내용이지만 구글이 뭘 의도했는지는 확실하지 않다"며 "현실에선 이런 시스템이 더 친환경적이고 유용한 기술에 비해 정당화되지 않는다"고 지적했다.

소프트웨어정책연구소는 달리 모델에 대해 "AI기반 생성 모델이 많이 활용되고 있는 패션이나 홈인테리어에 적용될 가능성이 높아 산업적 가치가 클 것으로 기대된다"면서도 "기술적 진보라기 보다는 오픈AI의 GPT-3 모델을 성공적으로 적용한 사례"라고 평했다.

19일 출간 전 논문 공개 웹사이트 '아카이브(arxiv)'에는 구글 브레인 연구원 3명이 공동 작성한 논문 '스위치 트랜스포머: 단순하고 효율적인 희소성을 사용해 조(兆) 단위 파라미터 모델 확장하기'가 게재돼 있다. 논문에 소개된 모델은 1조6000억개의 파라미터(모델 내부의 변수)를 사용한다. 최초의 '조 단위' 파라미터 모델이자, 현존 최대 규모의 모델이다.

파라미터는 모델이 처리하는 데이터를 계산해 결정되는 변수를 뜻한다. 파라미터가 많을수록 AI가 추론한 결과물이 정교해지지만, 그만큼 많은 데이터를 처리해야 하기 때문에 모델의 크기가 방대해진다. 동시에 이를 처리하기 위한 소요 시간과 처리에 필요한 전산 자원은 더욱 늘어난다. 결과물이 같다면, 단시간에 적은 자원을 사용하는 모델이 우수한 것이다.

특히 이 논문은 기존 대비 시간과 자원을 더 효율적으로 쓸 수 있는 기법을 연구해, 한정된 시간과 자원으로 데이터 처리 규모를 크게 늘린 성과를 제시하고 있다. 구글 연구진들은 최대 110억개 파라미터를 사용한 언어 모델 'T5' 시리즈와 동일한 연산 자원을 활용하면서도, 기존보다 4~7배 빠른 속도로 조 단위 규모의 파라미터를 사용하는 새 모델을 학습시켰다.

스위치 트랜스포머는 아직 연구자들에게 논문과 소스코드 형태로만 공개됐다. 이와 달리, 작년에 1750억개의 파라미터를 사용해 정교한 글을 쓰는 모델로 출시된 GPT-3는 외부 개발자들이 활용할 수 있는 현존 최대 언어 모델이다. GPT-3를 개발한 곳은 민간연구소 오픈AI지만 그 후원사 명단엔 역시 글로벌 빅테크 기업인 아마존과 MS가 이름을 올리고 있다.

오픈AI 달리(DALL·E)가 생성한 이미지 예시. [사진=오픈AI 웹사이트]

오픈AI는 올해 초 GPT-3를 활용해 '달리(DALL·E)'라는 또다른 AI 모델을 선보였다. 이 모델은 문장으로 표현하면 그에 맞는 그림을 만들어내는 '화가' AI다. "간판에 'GPT'라고 적힌 가게 앞", "아보카도 모양의 팔걸이 의자", "개를 산책시키고 있는 아기 조선무 일러스트" 등 사진 합성·편집부터 추상적인 개념의 연결과 사물 의인화까지 가능하다.

빅테크 기업들의 지원을 받고 있는 AI 연구진들의 경쟁 양상은 규모 싸움을 넘어 더욱 다양화되는 모습이다. 작년까지 오픈AI도 작년 GPT-3를 선보일 때까지는 기존 GPT 시리즈 모델에서 파라미터 수를 크게 늘리는 데 주력해 왔다. 하지만 GPT-3를 기반으로 만들어진 달리는 오히려 파라미터 수가 120억개로 오리지널 GPT-3보다 크게 줄었다.

다만 이같은 글로벌 기업들의 최신 AI 연구도 기존 대비 획기적인 패러다임 전환으로 볼만한 사례로 인정되진 않는 모습이다.

네덜란드 IT전문매체 더넥스트웹은 구글 브레인 연구진들의 스위치 트랜스포머 논문 내용을 소개하며 "더 적은 연산량으로 더 좋은 결과를 얻을 수 있는 기법이 가능하다는 내용이지만 구글이 뭘 의도했는지는 확실하지 않다"며 "현실에선 이런 시스템이 더 친환경적이고 유용한 기술에 비해 정당화되지 않는다"고 지적했다.

소프트웨어정책연구소는 달리 모델에 대해 "AI기반 생성 모델이 많이 활용되고 있는 패션이나 홈인테리어에 적용될 가능성이 높아 산업적 가치가 클 것으로 기대된다"면서도 "기술적 진보라기 보다는 오픈AI의 GPT-3 모델을 성공적으로 적용한 사례"라고 평했다.

[사진=게티이미지뱅크]

©'5개국어 글로벌 경제신문' 아주경제. 무단전재·재배포 금지

![[르포] 중력 6배에 짓눌려 기절 직전…전투기 조종사 비행환경 적응훈련(영상)](https://image.ajunews.com/content/image/2024/02/29/20240229181518601151_258_161.jpg)