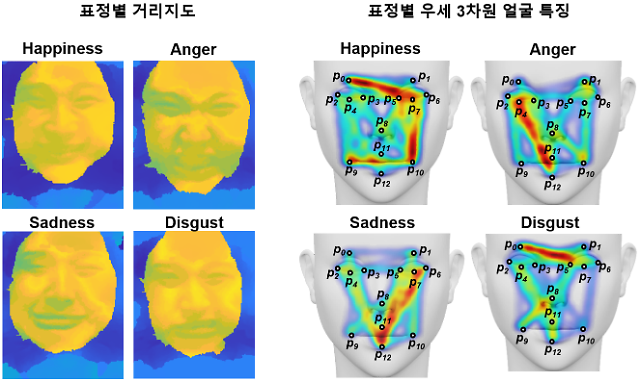

라이트필드 카메라를 통해 획득한 표정별 거리 지도(왼쪽)와 주요 3차원 얼굴 특징(오른쪽) [사진=KAIST]

3차원(3D) 이미지를 만들어주는 라이트필드 카메라가 사람의 감정을 읽을 수 있게 됐다.

카이스트(KAIST)는 정기훈, 이도헌 바이오·뇌공학과 교수 공동연구팀이 근적외선 기반 라이트필드 카메라와 인공지능(AI) 기술을 결합해 얼굴의 감정표현을 구분하는 기술을 개발했다고 7일 발표했다.

라이트필드 카메라는 한 번 촬영으로 빛의 공간·방향 정보를 획득한다. 이를 통해 다시점 영상, 디지털 재초점, 3D 영상 등 여러 영상 재구성이 가능하다. 하지만 기존 카메라는 실내조명에 의한 그림자와 미세렌즈 사이의 광학 크로스토크에 의해 이미지의 대비도와 3D 재구성 정확도가 낮아지는 현상이 발생했다.

연구팀은 라이트필드 카메라에 근적외선 영역의 수직 공진형 표면 발광 레이저(VCSEL) 광원과 근적외선 대역필터를 적용했다. 기존 라이트필드 카메라가 갖는 조명 환경에 따라 3D 재구성의 정확도가 낮아지는 문제를 해결한 것. 이를 통해 얼굴 정면 기준 0도, 30도, 60도 각도의 외부 조명에 대해, 근적외선 대역필터를 사용한 경우 최대 54%까지 영상 재구성 오류를 줄였다. 또 가시광선·근적외선 영역을 흡수하는 광 흡수층을 미세렌즈 사이에 넣어 광학 크로스토크를 최소화, 원시 영상의 대비도를 기존 대비 약 2.1배 정도로 향상했다는 설명이다.

KAIST 측은 "카메라의 기존 한계를 극복하고 3D 표정 영상 재구성에 최적화된 근적외선 기반 라이트필드 카메라를 개발했다"면서 "이 카메라로 조명 환경과 관계없이 피험자의 다양한 감정과 표정을 가진 얼굴을 고품질 3D 재구성 이미지로 획득할 수 있었다"고 강조했다.

획득한 3D 얼굴 이미지로 AI를 기계학습시켜 표정을 구분할 수 있게 됐다. 분류 결과 정확도는 평균 85%로 2차원 이미지를 이용했을 때보다 통계적으로 높은 정확도를 기록했다. 또 연구팀은 라이트필드 카메라가 인간이나 기계가 표정을 판독할 때 어떤 정보를 활용하는지 단서를 제공할 수 있다는 것을 확인했다.

정기훈 교수는 "연구팀이 개발한 초소형 라이트필드 카메라는 정량적으로 인간의 표정과 감정을 분석하기 위한 새로운 플랫폼으로 활용될 수 있을 것"이라며 "모바일 헬스케어, 현장 진단, 사회 인지, 인간·기계 상호작용 등 활용 분야도 다양하다"고 말했다.

이번 연구는 배상인 KAIST 바이오·뇌공학과 박사과정 졸업생이 주도했으며, 연구 결과는 국제 학술지 '어드밴스드 인텔리전트 시스템즈'에 지난해 12월 16일 온라인 게재됐다. 이번 연구는 과학기술정보통신부와 산업통상자원부의 지원을 받아 수행됐다.

©'5개국어 글로벌 경제신문' 아주경제. 무단전재·재배포 금지

![[르포] 중력 6배에 짓눌려 기절 직전…전투기 조종사 비행환경 적응훈련(영상)](https://image.ajunews.com/content/image/2024/02/29/20240229181518601151_258_161.jpg)